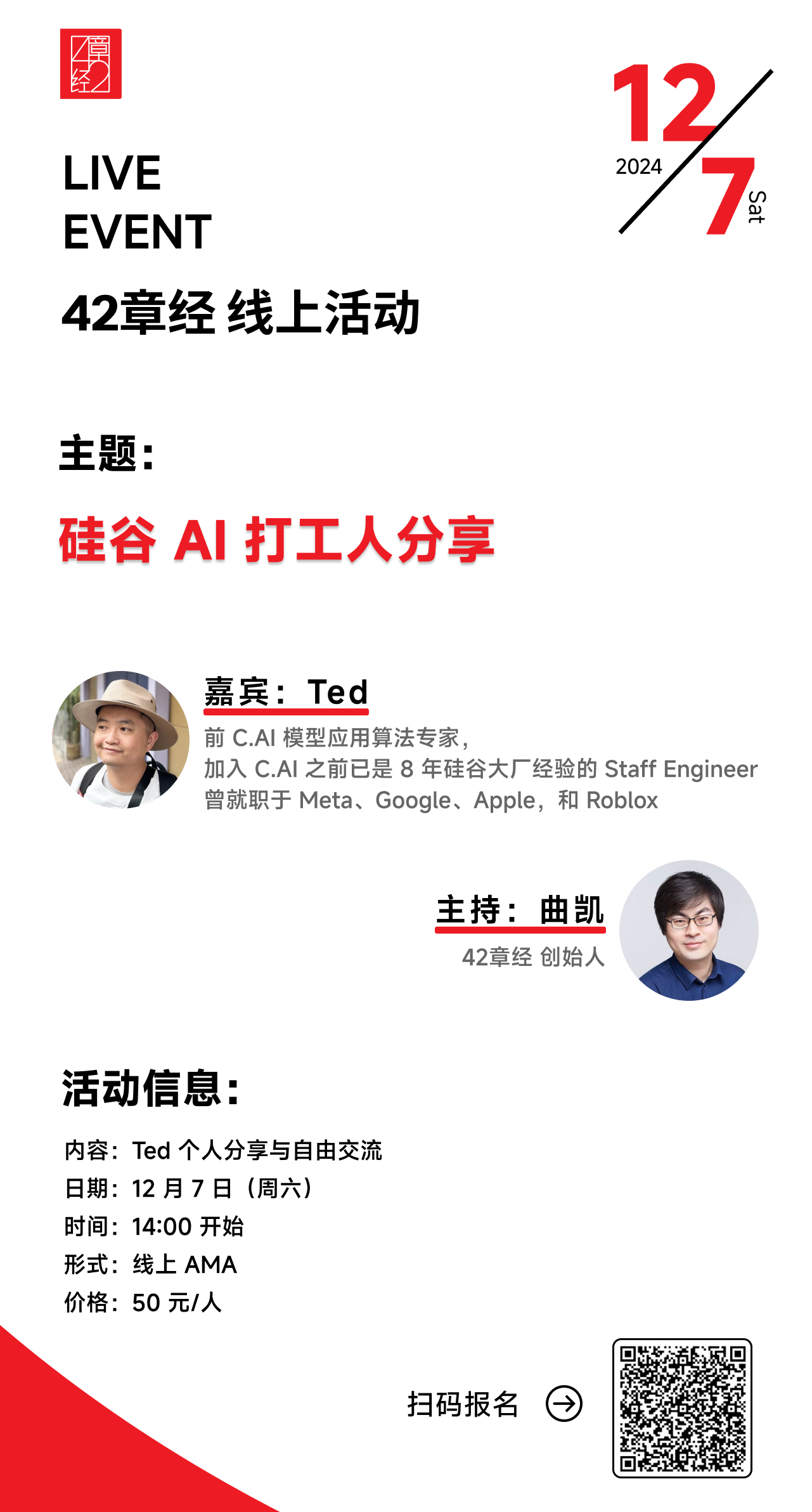

活动预告🥳:12 月 7 日,我们会请到 Ted 做一场线上活动,大家记得翻到 shownotes 末尾查看报名信息!

在我 9 月份的硅谷行程里,我见过的印象最深、让我最有收获的人之一就是 Ted。

那个时候他正要离开 Character.ai,作为第四十多号加入的员工,他对于 C.AI 的产品、模型、训练等等的熟悉程度都非常高,这次很开心能把他请来,跟大家一起分享下美国最著名的 AI 公司内部是如何运作的,Post Training 的最佳实践是怎么做的,以及硅谷一众 AI 从业者的现状和认知等。

这期播客的内容基本代表了美国最一线的 AI 从业者的实践和认知,非常有代表性,希望对大家有帮助!

最后,我们的 AI 私董会也在持续报名中,目前已经聚集了一批市场上最好的 AI 创始人,欢迎点击链接报名(里面也有目前已加入的成员名单,可点击查看)

【人类博物馆】

导游:曲凯,42章经创始人

28 号珍藏:Ted,前 C.AI 模型应用算法专家

Part 1 从内部视角看 C.AI

- 01:06 为什么商业化一直没做起来?

- 04:40 如果 C.AI 当时往 AGI 赌把大的,或者把产品交给字节系,能改写自己的结局吗?

- 06:51 我们很认可 Talkie,但不想学 Talkie

- 09:36 被收购后,你还相信 C.AI 类产品的未来吗?

- 11:35 有人说「C.AI 不是真正的 AI 陪伴」,那它到底是啥?

- 12:19 C.AI 为什么做得比别人好?

Part 2 我在 C.AI 做 Post Training 的这一年

- 14:56 工作状态是 996(主动的哈,passion!

- 17:15 Post Training 的核心是设计高效的迭代路径

- 24:19 Post Training 到底是怎么个流程?

- 25:37 介绍 Post Training 三大件:SFT(监督微调) 、RLHF(人类反馈强化学习)、DPO (直接偏好对齐)

- 32:07 以上天花板极高,RAG 和 Prompt Engineering 我们几乎没做

- 32:53 帮你拉开和同行差距的 2 道数据思考题:

- 39:32 大家现在关注的几个技术难题,C.AI 是怎么做的?

Part 3 硅谷观察

- 46:17 一个不被公开的秘密:ChatGPT 内部也是多模型混用?

- 47:28 硅谷整体还是很乐观,推理侧仍然大有可为

- 50:45 硅谷现状:

- 53:48 复盘最近的硅谷求职记

- 53:54 Post-train 人才极其抢手

- 54:27 印象最深的是,面 Cursor 的时候,我甚至被允许用 Cursor 现场解题

- 56:03 最喜欢被问到「你觉得我们的 idea 有多不靠谱?」

- 56:45 如果我是面试官,我会考察面试者的这项直觉能力

- 57:28 我很喜欢现在硅谷的氛围!当下可能是华人扬眉吐气的最好时机

【活动预告🥳】

12 月 7 日,我们会请到 Ted 做一场线上活动,感兴趣的朋友欢迎点击链接或扫描下面的二维码,一起来认识&交流!

【The gang that made this happen】

- 制作人:陈皮、Celia

- 剪辑:陈皮

- Bgm:Mondo Bongo - Joe Strummer & The Mescaleros

14233

14233 54

54